Il y a quelques semaines, j’avais la chance de me rendre à Que Du Web 2015 avec Cédric Guérin qui pilotait le véhicule depuis Rennes. Nous étions quatre, avec Annick Techer et Luc Page. Petit clin d’œil à Nils Talibart, croisé là-bas et aussi seo rennais.

Mon modeste compte rendu de Que Du Web à Deauville

Liste des conférences :

- Daniel Jarjoura, le growth hacking

- Julien Deneuville, clustering pour le webmarketing (exposé flash)

- Grégory Castel, le e-tourisme

- Lydia Arzour, le référencement 2.0

- Eric Leandri, Qwant le moteur de recherches

- Olivier Andrieu, historique du SEO

- Aurélien Delafosse, checklist SEO

- Serge Esteves, un Duplicate Content surprenant (exposé flash)

- Jean Benoît Moingt, le SEO chez Pages Jaunes

- Maxime Legendre, crawler rapidement (exposé flash)

- Thomas Largillier, étude webspam

Mes notes ne sont pas toutes aussi nombreuses d’une conférence à l’autre, mais il n’y a aucune corrélation avec la qualité supposée, bien entendu…

Que du bon en organisation

Jeudi 4 juin 2015, nous étions reçus au centre international de Deauville pour Que Du Web, et des conférences dans l’amphithéâtre Lexington, à quelques mètres de la plage.

Sylvain Peyronnet était le chef d’orchestre de cette journée, avec discours inaugural et discours de clôture, assurant le mien d’un certain rythme entre deux conférences. Le rendu final, très dynamique, était très bon.

En outre, l’organisation générale était bien huilée avec une signalétique suffisante, une pause du midi avec tout ce qu’il fallait, une équipe très accueillante, un amphithéâtre confortable et parfaitement sonorisé, y compris lorsque les conférenciers posaient des questions en fin de conférences.

Et un hashtag #QueDuWeb qui a connu son moment de gloire et ses pépites de réappropriations.

Ça c’est de la bonne pub ! RT @Interflora: On ajoute un peu de nature pour qu’il n’y ait pas #queduweb <3 pic.twitter.com/usDDoXybWm

— Seo Romantique (@xavfun) 4 Juin 2015

Ah oui, il y avait aussi des conférences de manière générale excellentes… 45 minutes pour les conférences et 10 minutes pour les exposés flash. Ci-dessous, je vous propose mes notes très loin d’être exhaustives vis-à-vis de certaines interventions très riches.

Le Growth Hacking

Daniel Jarjoura de StartUp42 présente Growth Hacking: buzz ou vraie méthodologie ?

Qu’est-ce que le growth hacking ? S’il y avait trois points à retenir, selon Daniel Djarjoura, les voici.

Les techniques d’ingénierie pas cher

Le growth hacking, il s’agit donc de techniques peu onéreuses au regard du coût que pourrait représenter des campagnes publicitaires.

Exemple : hotmail qui fut créé par 2 ingénieurs de la Silicon Valley.

300 000 dollars d’investissements publicitaires en ligne et en affichages n’ont rien donné. Puis l’idée fut de glisser dans le footer de chaque mail ce message automatique : PS: I Love You. Get Your Free Email at Hotmail. Un an et demi plus tard, il y avait 12 millions d’utilisateurs, et ce fut le jackpot avec la revente à Microsoft.

Focus sur la croissance des utilisateurs

Croissance des utilisateurs ou encore croissance de la base clients, c’est le B.A.-ba. Idée soutenue notamment par Sean Ellis. C’est comme cela que Dropbox vous offre de l’espace de stokage gratuit à chaque parrainage.

Et lors d’une inscription sur un réseau social comme Twitter, on vous oblige dans un premier temps à suivre quelques personnes, car on sait que cela augmente vos chances d’être suivi en retour.

La mesure du résultat

Il faut faire appel à des métriques pour la décision. Sur des sites de shopping, un moyen consiste à faire de l’A/B testing sur la manière de visualiser les produits et mesurer les différences d’interactions et les résultats.

En résumé, le Growth hacking c’est peu onéreux, cela consiste à faire grandir sa base utilisateur et à mesurer ses résultats. Une philosophie plus qu’une méthodologie.

Il s’agit aussi parfois de méthodes pirates. La technologie est souvent en avance sur la législation alors pourquoi ne pas en profiter pour s’installer. Une fois la loi en application, la croissance nécessaire à l’atteinte du seuil critique d’utilisateurs est déjà obtenue.

Clustering pour le webmarketing

Julien Deneuville, SEO chez OneClic.

Il use de trois exemples pour explorer un univers sémantique, segmenter une base utilisateurs ou encore réutiliser les données apprises. On remarquera l’utilisation du logiciel Gephi.

C’était intéressant, et il a eu la bonne idée de développer cette présentation dans un article plus complet sur le blog de sa société : pureside.fr

Le e-tourisme français

Grégory Castel de SoNumérique.fr nous parle du numérique dans le secteur du tourisme, sous le nom de conférence suivant : Lisibilité, Visibilité, Hospitalité : le triptyque vertueux d’une stratégie digitale de marque pour les territoires et destinations ?

Cette conférence était extrêmement dense et je l’ai particulièrement apprécié alors que je suis totalement éloigné des intérêts du sujet.

Il nous met en évidence que la France (et l’Europe) sont très en retard en ce qui concerne le virage numérique du secteur de tourisme. La France se cache souvent derrière le mythe du pays numéro du tourisme, mais attention, on y passe plus qu’ailleurs, certes, mais on y dépense moins qu’ailleurs, indice de ce malaise numérique.

En effet, 80% des européens préparent leur vacances sur le web, et 60% règlent avec un paiement en ligne, et notre offre est très en retard. Cela explique que le tourisme rapporte plus aux USA et à l’Espagne.

En 2014, la FEVAD a constaté le premier recul des ventes de voyages en ligne en France, dans un secteur où les ventes sont toujours en croissance, encore un signe du retard français.

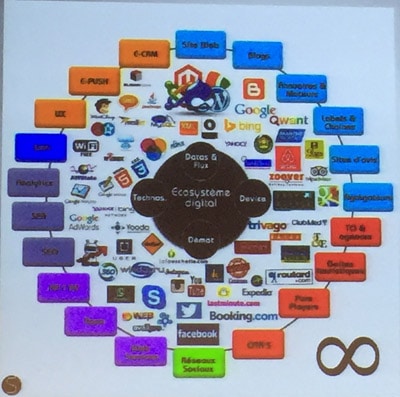

Voilà ce qu’est l’environnement du e-tourisme aujourd’hui :

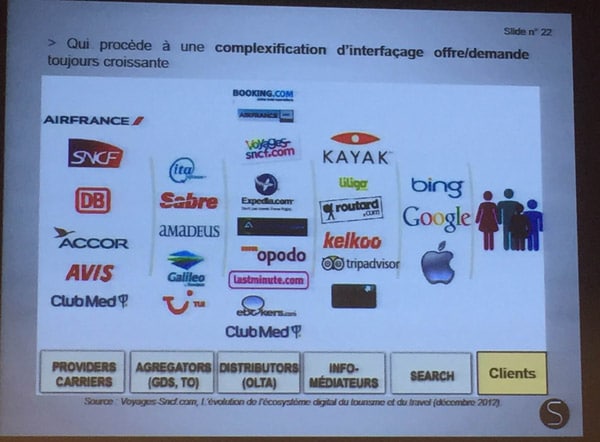

Une demande face à une offre de plus en plus en complexe, dont le premier acteur est le moteur de recherches :

Celui qui est le plus puissant est à droite de cette image.

Du coup, les OTA captent 33% des réservations hôtelières après que 82% des touristonautes soient arrivés par Google. Celui qui est le plus puissant est à droite de cette image.

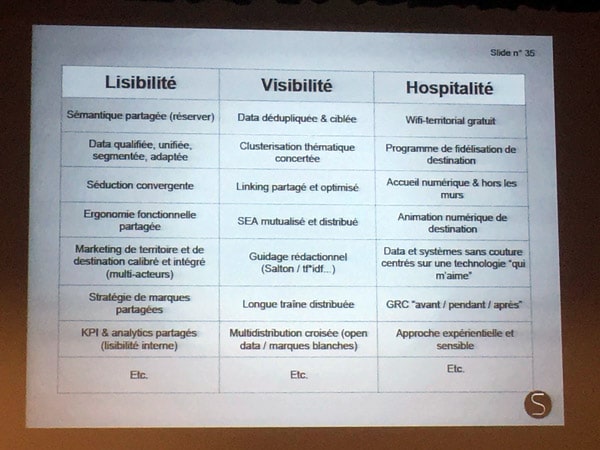

Lisibilité, visibilité et hospitalité, le tiercé pour gagner

Quand on sait que les spécialistes du e-tourisme français sont de vrais champions du duplicate content, on comprend encore mieux nos difficultés.

Il faut donc que les acteurs révisent les bases, mais surtout qu’ils prennent conscience de l’importance du retard stratégique qui est pris. Et par acteur, on parle aussi des pouvoirs publics qui ne voient pas le danger venir.

Le référencement 2.0

Lydia Arzour nous présente Le référencement : L’arme fatale d’une stratégie e-marketing efficace.

Lydia Arzour sur la scène de Que du Web

Une conférence qui a retenue l’attention de toute l’audience, par son contenu et sa présentation tout en nuances.

Le search marketing représente 50% du trafic d’un site web. Et souvent, omnibuler par les fortes croissances de géants tels que Facebook, on a tendance à oublier que le nombre de recherches effectuées dans les moteurs de recherches ne cesse de croître année après année.

Le référencement est donc incontournable, mais il faut aller plus loin pour gagner en efficacité.

Le référencement, un des levier de l’inbound marketing

Si l’Outbound Marketing, c’est aller vers son prospect, l’Inbound Marketing consiste à attirer le client. Et attirer le client, c’est notamment possible via le SEO.

On va pouvoir industrialiser le processus de création de contenu, et non pas la création, on parle alors de Marketing Automation. On retrouve alors des techniques telles que webinaires, livres blancs, etc.

Google est Moteur de réponses

Pour 90% des industries, on compte 40% de génération de prospects après le premier clic en Search. Mais attention car la donne évolue avec des moteurs de recherches prenant en compte le web sémantique, l’intelligence artificielle et l’expérience utilisateur UX. Il faut utiliser les données SEA et SEO pour analyser les données de navigation de ses clients et prospects pour faire progresser son site.

ATAWAD : Les internautes nous cherchent partout, et tout le temps (AnyTimeAnyWayAnyDevice), c’est pourquoi il faut être présents, mais pas n’importe comment.

Le référencement doit donc lui aussi être 2.0

Le contenu est pluriel, que ce soit une page, un article de blog, une vidéo, un statut Facebook, un tweet, un e-mail, ou encore un SMS, il faut optimiser ce contenu. Lydia parle référence de contenu.

La viralité et l’intention de cliquer est généralement rattachée à une émotion. Par exemple, si vous êtes sur ce blog, vous avez forcément déjà entendu parler par ailleurs d’articles prédisant la mort du SEO. Le SEO est mort ? Ok, on ne sait pas ce qu’il y a derrière l’article mais on a envie de cliquer. Et l’émotion opère car nous sommes dans la cible.

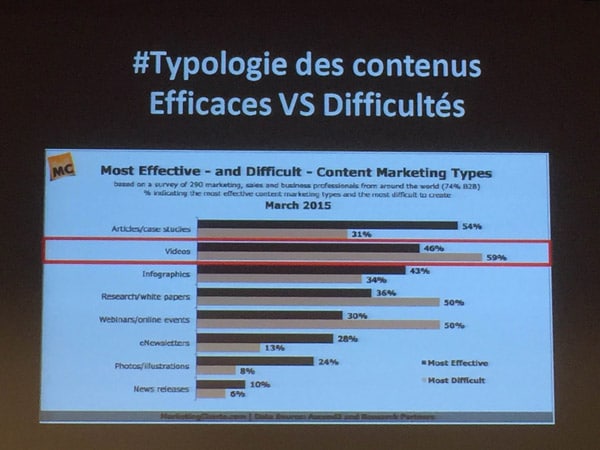

Il est à noter aussi que selon CISCO, le contenu vidéo représentera 69% de tout le trafic Internet en 2017. Cela donne des perspectives en matière de viralité…

Selon le type de contenu, la difficulté de pénétrer le cerveau est plus ou moins complexe. Et la temporalité jouera aussi, car en période de solde je suis plus à l’écoute des messages parlant de rabais.

Efficacité des contenus

De manière générale, il ne faut pas oublier que le contenu est intention. Il faut se demander qui sont vos internautes et penser intentions en amont et en aval, plutôt que mots-clefs.

Et s’il y avait un but ultime à se fier, c’est faire sans Google, en mettant en pratique des notions de rétention, fidélisation, et de communauté.

Lors des questions, Lydia Arzour répond qu’au sein du tissu professionnel français, à 95% des PME de moins de 20 membres, pas toujours sensibilisées et armées face au web, et il faut passer par de l’évangélisation. Gageons que ses clients sont tous convertis à la religion du référencement web 2.0.

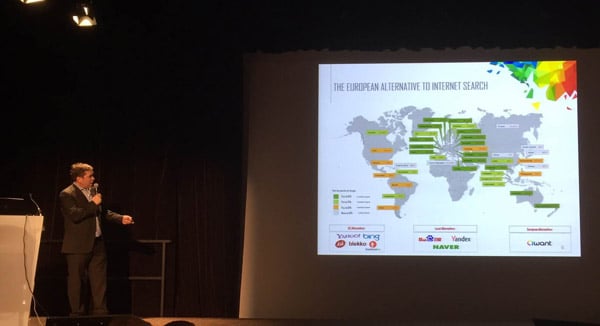

Qwant, un moteur de recherches qu’il faut essayer

Eric Leandri est le co-fondateur de la société Qwant, spécialiste en sécurité de l’informatique, et il intervient sous ce titre : Qwant, un moteur de recherche différent, et pertinent.

Qwant, seule alternative crédible à Google en Europe

Il nous présente la nouvelle version de Qwant.

Une liste d’arguments longue comme le bras

Vous pouvez avoir confiance dans le service proposé, notamment car :

- Il n’y a pas de cookies de tracking

- La certitude de rester anonyme dans ses recherches (data minimization).

- La barre horizontale présentant des images se transforme en shopping selon la requête.

- La sortie de Qwant Junior, voir-dessous

- Une monétisation révolutionnaire des annonces publicitaires, voir en fin de présentation.

- etc.

Notre orateur répondait au passage au fait qu’ils sont pour la neutralité du net et qu’ils communiquent leurs désaccords auprès du gouvernement français à ce sujet. Il nous invite aussi, nous SEO, à nous pencher plus sur le PLR Projet Loi renseignement, à commencer par écouter l’interview du très bon Benjamin Bayart sur le site de Korben info.

Qwant Junior, un cheval de Troie qui nous veut du bien

Qwant junior est un moteur de recherches sans violence et sans site pour adulte. Ce moteur présente un onglet éducation pour trouver les résultats qui permettront au jeune internaute d’apprendre sur le sujet demandé. Par exemple, si j’y tape italien, alors cet onglet éducation renvoie des résultats pour savoir comment et ou apprendre l’italien. Pour fonctionner, cet onglet fait appel à une white liste.

Qwant junior pourrait intégrer les écoles françaises. Ce qui me semble un levier idéal pour une croissance du moteur. Les enfants pourront évangéliser leurs parents vis-à-vis de Qwant et du respect de la vie privée.

Un index européen

C’est une réalité, Qwant crawl aujourd’hui 40 millions de pages, et les indexe, chaque jour. Tout est stocké sur des serveurs en France. Le moteur redonnera les résultats comme cela :

- Web Search : résultats les moins biaisés possibles

- Social Search

- Local Search : pour tenir compte du local avant d’afficher les résultats

- News Search : il s’agira de tous les articles qui font sens sur une actualité. Aucune liste blanche, et même la possibilité de rétribution financière pour chacun selon le nombre d’apparences sur Qwant news.

- Commerce : affichera aussi ce qui concerne le voyage. Tripadvisor et Yelp sont déjà entrés dans un processus d’accès à leurs données.

Le système Adwords à la mode Qwant

Eric Leandri nous fait alors une démonstration de la future monétisation possible des SERPs de Qwant, en d’autres termes le Google Adwords à la française, à l’européenne.

Sur Google, les pubs sont sur les côtés et, de plus en plus, tout en haut de la page, à tel point que le premier résultat naturel est parfois caché en dessous de la ligne de flottaison.

Sur Qwant, la publicité va enrichir les résultats naturels. A savoir que si vous êtes 8ème, alors vous pouvez ajouter des photos, un message publicitaire, une promotion dans un espace supplémentaire, mais cet espace se glisse sous votre résultat naturel. Et donc, la pertinence des résultats n’est pas polluée par la loi du plus offrant. Cette idée est juste géniale. Ceci est une révolution, camarade SEO.

Avenir de Qwant

Pour aider Qwant, il s’agit de donner son avis, sur ce qui plait, ce qui ne plait pas, pour faire progresser le service.

Prochainement, nous verrons arriver Qwant Music qui présentera sa White Liste à la manière de Qwant Junior. Dans la partie principale web, j’aurai tous les résultats, avec des sites en tout genre. Mais si je veux être certain d’être sur un site de téléchargement légal par exemple, et bien Qwant Music répondra à ce besoin.

L’horizon de la rentabilité est fixé à 2020.

- Qwant représente déjà plus d’1% de part de marché aujourd’hui en France

- 1,5% de PDM sur un pays correspond au seuil de rentabilité

- 2% de PDM en France permettrait d’être le 2e moteur de recherches sur notre territoire.

- 2,5% de PDM en France est l’objectif d’ici un an.

- 5% est l’objectif secrètement visé.

Pour conclure, je rajouterai que Qwant me plait bien. Et surtout, il nous veut que du bien. Pour preuve, le passage imminent de son interface front office en Open Source. Essayez-le.

Le Pape nous retrace l’historique de la religion SEO

Olivier Andrieu d’Abondance, déjà présent à Angers dans le cadre de la table ronde des dinos du SEO, nous livre cette fois sa vision historique du métier, dans une conférence intitulée D’où vient et où va le référencement ?

L’ère glacière de 1993 à 1998

Une ère où règne l’ultra spamming sur Alta Vista.

Le jurassique de 1999 à 2010

C’est l’arrivée de Google, et grâce à la pertinence du moteur, le spam chute.

On se réfère alors à la règle des 4C Code Conception du site, Contenu et les LIENS (Célebrité).

- Code : Hn title etc

- Conception : URL, crosslinking, etc.

- Contenu : 200 mots au moins, maillage

- Célébrité : plus en quantitatif qu’en qualitatif

Le Cénézoïque de 2011 à 2015

Le SEO industrialise le spam aux liens mais Google réagit avec Panda en 2011, Penguin en 2012 et Hummingbird en 2013. On voit apparaître la prise en compte des concepts, de la sémantique.

Aujourd’hui, on peut alors se demander ou en est la règle des 4C ?

Code : il y a du nouveau avec le balisage sémantique et d’autres balises.

- Le balisage sémantique

- Les rich snippets sont un ajout dans les SERPs

- Le balise schema.org pour aider le moteur à mieux comprendre la page (sans forcément des rich snippets ensuite dans les résultats de Google).

- La balise de pagination

- On devrait les mettre à chaque fois, ça fait du bien au crawl.

- La Balise de géolocalisation

- Tout simplement langue-pays

- La balise authorship

- Cette balise est morte même si l’idée n’est pas totalement abandonnée par le moteur californien.

- La balise news_keyword pour Google News

Conception : il faut désormais tenir compte

- Du temps de chargement des pages

- Pour l’internaute, et pour les robots crawler même s’il n’y a pas un impact direct sur le ranking

- De la sécurisation https

- Même si là aussi, l’impact est pour le moment nul sur le positionnement

- De la compatibilité mobile

- Un choix à faire plus pour l’internaute que pour Google

- De la désindexation, depuis Panda, et ne pas garder

- ni les pages issues de résultats du moteur de recherches interne,

- ni les pages faibles en texte

- ni les formulaires

- ni les PDF, selon vos choix personnels

- De la prise en compte du Duplicate Content

- De l’importance moindre des textes visibles après un clic (onglets ou accordéons)

- De la gestion de la navigation à facette avec indexation ou pas

- De la baisse du poid des EMD

Contenu

- Il y a une prise en compte de la richesse sémantique.

Célébrité

- Il faut parfois nettoyer son profil de liens

- Il faut garder en tête que l’ancre du lien véhicule un sens

- La fin du Tool Bar PageRank

Il y a aussi l’arrivée des pénalités, des réseaux sociaux (aujourd’hui sans impact direct) et du not provided. Mais quel est l’avenir du SEO ?

L’ère Star Trek de 2016 à ….

Pourquoi Star Trek Monsieur Spok ? parce qu’on pose la question et le moteur donne de suite le réponse.

Le moteur de réponse c’est déjà aujourd’hui ce que l’on voit avec la météo dans Google.

Pour trouver ses réponses, Google s’appuie sur Freebase et ses entitées nommées, mais aussi sur du scrapping sauvage du web. Cela amène à une nécessité de diversifier ses sources de trafic, car l’hégémonie de Google en Europe lui donne un droit de vie ou de mort sur votre service, si demain il vous court-circuite par exemple. D’ailleurs, le naturel (autre que GG), c’était 53% de ce qu’il y avait au dessus de la ligne de flottaison en 2008, et 18,5% maintenant.

L’authorank est une idée que Google n’a pas écarter, de manière algorithmique.

Pour devenir un expert, il faudrait une unicité des thématiques, une analyse des BL, une analyse des réseaux…

L’anticipation

Avec Google Now comme avec SIRI, et selon votre historique de recherches mais aussi votre historique de localisation, le moteur vous conseillera sur votre besoin, avant de le ressentir. Personalisation et contextualisation de sont pas loin.

On peut voir ce que Google sait sur moi ici : http://www.google.com/ads/preferences/ (en mode connecté c’est mieux).

Et le mobile : bientôt 50% des recherches

Ah oui, pour la gestion des données personnelles, vous avez des moteurs comme Qwant !

La checklist du SEO

Aurélien Delefosse de E-Influence nous présente la Check list d’un audit SEO et cas concrets.

Quelques idées retenues en vrac

- Des URL claires et fixes : attention à ne pas glisser de majuscule dans une URL, vous risqueriez le Duplicate Content. Faîtes une 301.

- Un chargement rapide des pages : comme le dit GWT, si le temps augmente, le nombre de pages crawlées baisse.

- Penser hiérarchisation des contenus, arborescence en silo, maillage interne et éviter les liens site wide en footer.

- Titres uniques et optimisés : à noter que les fautes d’orthographes marchent moins bien qu’avant.

- Faire des liens ? les annuaires marchent encore, on peut trouver du lien via notre activité IRL (salons pro, CCI, mairie, …) ou en faisant des partenariat ou sponsoring (mais attention à éviter les sites qui changent leur sites tous les ans.

- Du linkbaiting, des avis sur vos fiches.

- Analytic : regarder les pages d’atterrissage du search, et vérifier les dates des filtres Google si le trafic est à la baisse.

Cas de duplicate content étonnant

Serge Esteves de la société Creapulse nous fait un exposé flash, sur un cas de site où des pages dupliquées et moins riches faisaient plus de trafic que les bonnes pages.

Il nous montre le raisonnement et la méthode pas à pas permettant d’en trouver la cause.

Cas intéressant, traitant donc de la présence de l’URL dans le code source aux Backlinks, en passant par l’analyse du sitemap.

Le SEO chez Pages Jaunes

Jean-Benoît Moingt de Solocal Group, nous fait son Retour d’expérience : naissance du SEO dans un grand groupe.

Il faut savoir que le site pagesjaunes.fr est créé en 1996, et jusqu’en 2011, le SEO c’est environ nada, sans même aucun suivi. Jean-benoit nous raconte la mise en place du service SEO en trois étapes.

Objectif qualité des pages semble dire le panda de Jean Benoït

Evangélisation

La direction, le service marketing, les commerciaux qui s’en servent désormais comme argument de vente, et les développeurs.

Mise en place

Des consultants SEO avec un profil technique du type moutons à cinq pattes. Et comme on dit la-bas, celui “qui n’a jamais fait péter EXCEL n’a jamais travailler sur des gros volumes“.

Passer à l’action

Monitoring avec Kibana notamment. Il a fallu automatiser ce monitoring avec des dashboard SEO. Et créer des outils spécifiques comme Kill Peak pour voir la saisonnalité de tel ou tel mot-clef.

Roadmap et prospectives SEO

Des mises en productions plus régulières. Il ne faut plus attendre une des quatre mises en production annuelles pour changer un title.

Qualité des pages

Il y avait un problème de génération de pages de mauvaises qualités. Vous tapez station de ski montpellier, la page est vide, et donc de mauvaise qualité. Aujourd’hui, un arbre de décision automatique donne un score de fragilité et élimine toutes ces pages de mauvaise qualité.

Il y a une vrai recherche de génération de trafic utile, c’est à dire à destination des professionnels clients de pages jaunes.

Structure du site

Il a fallu passer d’un classement sémantique de l’annuaire papier à une sémantique web, répondant aux requêtes des internautes. Désormais, l’avis du SEO est pris en compte et le site est de plus en plus optimisé.

Reste plus qu’à souhaiter bonne chance à son équipe pour la future version du site des pages jaunes.

Optimer le crawl pour de gros sites

Maxime Legendre de One Clic nous parle ensuite de l’optimisation du crawl.

Objectif, 2,5 millions de pages crawlées en 5 heures.

Ce devait être le moment de la digestion… je n’ai malheureusement pas plus de notes, mais ce devait être super quand même !

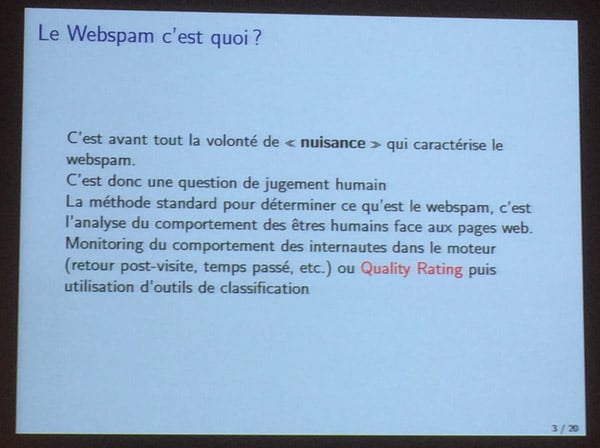

Etude Webspam

Thomas Largillier, maître de conférences à l’Université de Caen nous fait un Retour sur l’étude Webspam dans laquelle il était question de définir qu’est-ce qu’un contenu de qualité.

Tout d’abord, il faut rappeler que cette étude est toujours en cours, et que vous aussi vous pouvez y contribuer en allant sur webspam.peyronnet.eu

Chaque participant voit des pages web et indiquent si cela leur semble être du spam, de la basse qualité ou de la haute qualité.

Quelques critères évalués au regard des résultats

- TLD : les .info sont plus souvent spamés que les autres

- Taille du domaine

- Taille du Title : à noter que la triplette du bourrin semble évitée sur les pages… jugées spammy.

- Ratio No Follow / Do Follow dans le contenu : Utiliser du nofollow serait symptomatique de pages de basse qualité ou spam.

- Les partages Facebook

- Le taux de compression

- etc.

S’en suit une série de questions où Sylvain et Guillaume Peyronnet entrent en jeu pour les réponses. On y apprends que les cobayes permettent à un algorithme d’apprendre à détecter le spam, donc à simuler Panda. A bon entendeur, il est aussi rappeler qu’un bon spin est indétectable… Surtout, il faut plus de notations pour avoir des données permettant d’analyser des critères plus complexes, structurels. Inscrivez-vous ! Surtout qu’un webinar est en prévision cet été.

Un grand merci aux organisateurs, mais aussi à Renardudezert pour l’invitation.

Les frères Peyronnet

Si j’ai écris une bêtise, vous pouvez me le signaler, je ne suis pas susceptible. Et puis si vous voulez dire un truc sympa en commentaire, je ne suis pas émotif non plus. Ah oui, j’ai failli oublié, il y un article compte rendu différent mais bien plus sympa à lire sur le site de Nicolas Auge ici.

Hello Mister.

Très beau compte rendu qui a assurément du demander beaucoup de temps alors bravo !

Je pense qu’il y a pas mal de monde de content que tu ais fait un article aussi dense et détaillé.

Bon, c’est pas tout ça mais c’est le moment de faire un lien vers cet article. ;-)

Merci pour ce long et détaillé compte-rendu. Au plaisir de discuter ensemble lors d’un apéro à Rennes.

Par contre, tout comme Nicolas, pourquoi faire des liens vers Twitter, vous avez été engagé pour faire le SEO du site ? ;)

Pas faux. Pour la peine, je fais amende honorable et je mets ton lien vers e-influence dans l’article, et celui vers le compte twitter Gwaradenne derrière ton commentaire.

M. Twitter, si tu nous regarde, et que tu recrute pour ton SEO, ça m’intéresse aussi ;-)

PS : avec plaisir pour la discussion à Rennes !

Ça c’est du compte-rendu ! Merci pour le clin d’oeil, content d’avoir enfin croisé une partie de la team SEO rennaise, en espérant rapidement pouvoir prendre part à un apéro SEO à Rennes :)

Bonjour Régis,

Merci pour ce compte rendu ..efficace pour les gars du sud qui n’ont pas pu se déplacer ! Un petit commentaire sur les pages jaunes.. j’ai dû les quitter en 2007..j’avais trop honte de vendre les produits sans visibilité sur le grand G. ..puis arriva “le messie” du Seo (hello Jean Benoit) ..Il est vrai que G. et un annuairiste n’ont pas les mêmes objectifs au départ, Google étant plus adversaire potentiel que partenaire , se mettre dans le gueule du loup au risque de se faire croquer …mais depuis, le temps a fait son oeuvre, mais que de temps perdu !

Compte rendu top ! Bravo !

Pour ceux que ca intéresse, les slides de ma présentation : http://www.slideshare.net/djarjoura/le-growth-hacking-que-du-web